Первое знакомство с A-parser

Автор: admin_site

Дата создания: 22 Mar 2025

Я приобрел на прошлой неделе лицензию A-parser. Купил версию Enterprise, чтобы иметь возможность работать через API.

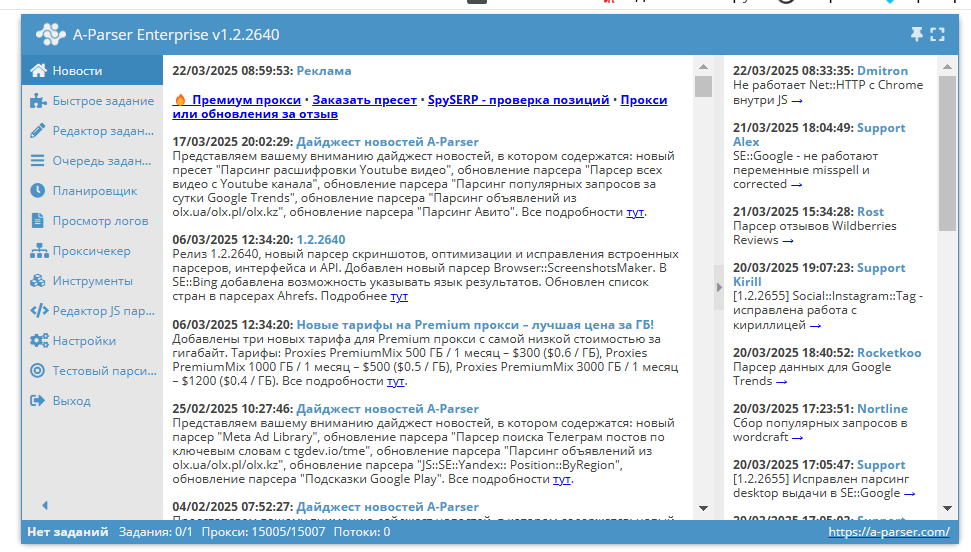

У меня есть свой сервер, - на него я установил docker и через него установил и запускаю A-parser. Вот как выглядит интерфейс

Очень не просто оказалось разобраться в интерфейсе. И не сразу получилось запустить задачу. Сначала потребовалось настроить проксичекер, этот раздел хранит все прокси и проверяет их живучесть. После этого смог запустить свою первую задачу.

Но у меня появились вопросы. При покупке мне дают 50 потоков, и прокси - 15 тыс., которые регулярно обновляются. Но так как это общие прокси, то часто они заскамлены поисковыми системами, и очень часто появляется капча. Чтобы все таки спарсить выдачу поисковой системы (а это и есть моя цель) есть 2 пути: либо увеличивать количество попыток запроса - к примеру от стандартных 10 до 100 попыток, либо подключить антикапчу. Первое увеличивает время парсинга, и не гарантирует результат, второе - увеличивает стоимость парсинга.

У меня простая задача - проверка индексации страниц в Яндекс и Google. Но проверить нужно 120 тыс. страниц. Итого 240 тыс. запросов к обоим поисковым системам. Чтобы это было хоть сколько нибудь недорого и быстро - необходимо брать минимум 300 потоков, а это около 17 тыс. рублей в месяц. Цена вполне оправдана, если проверять индексацию хотя бы 4 раза в месяц и выполнять другие задачи, например, отслеживание позиций. К примеру, в TopVizor мы сейчас платим свыше 35 т.р. только за отслеживание позиций. Если создать свою инфраструктуру по мониторингу позиций, то будет выгодней использовать a-parser.

Но все это нужно тестировать, так как важна не только скорость обработки заданий, но их точность. Например, я отправил на проверку индексации 2 страницы, в Яндекс и Google. Количество попыток - 100. В результате я получил только 2 результата из 4. Это очень сильно смущает.

Можно использовать также прокси, где цена за траффик. Пишут об их качестве, что капчи почти не случаются. Но вот вопрос - парсинг выдачи Яндекс и Google, массовый парсинг - не станет ли он "золотым", смогу ли я удержаться в рамках заданного месячного бюджета.

Был небольшой эксперимент, я завел в а-парсер свои 5 прокси, 4 shared на троих, и 1 индивидуальный и запуcтил проверку индексации Google - 12 тыс. страниц, парсер остановился на примерно 2 тыс страниц, и прокси ушли в бан. Это хороший показатель, так как они работали без капчей. К сожалению не помню процент неудачных запросов.

В общем, я продолжаю тестировать парсер. Какие планы:

- Разобраться работает ли а-парсер с ipv6, и можно ли с их помощью парсить выдачу яндекс и гугл.

- Протестировать работу премиальных прокси за траффик. Попробовать подключить сторонние прокси за траффик.

- Пробовать парсить позиции ключевых фраз.

- Купить 100 качественных прокси на стороне (когда я пишу сторонние или на стороне, это значит ,что купить не у a-parser) и попробовать работать с ними.

- Изучить возможности a-parser по гибкой работе парсинга.

- При необходимости разработать свою логику гибкой работы парсинга

- Изучение документации а-парсера. Там действительно много чего лежит под капотом, да и множество парсеров нужно еще протестировать, которые могут быть полезны в работе seo.

Кстати, вот сертификат с курса Дмитрия Шахова, который я прошел в марте: